一、SGL [2020]

《Self-supervised Graph Learning for Recommendation》

用于推荐的

representation learning on user-item graph已从使用单个ID或interaction history发展到利用高阶邻居。这导致了图卷积网络 (graph convolution networks: GCN)在推荐领域的成功,例如PinSage和LightGCN。尽管有效,但我们认为它们存在两个局限性:(1):high-degree节点对representation learning产生更大影响,从而降低low-degree items(长尾items)的推荐效果。(2):representations容易受到noisy interactions的影响,因为neighborhood aggregation方案进一步扩大了observed edges的影响。

在这项工作中,我们探索了

user-item graph上的自监督学习,以提高GCN在推荐中的准确性和鲁棒性。这个想法是用辅助的自监督任务来补充经典的监督推荐任务,这通过self-discrimination来强化node representation learning。具体而言,我们生成一个节点的多个视图,最大化同一节点的不同视图的一致性(与其他节点的不同视图之间比较)。我们设计了三种算子来生成视图:node dropout、edge dropout和random walk,它们以不同的方式改变图结构。我们将这种新的学习范式称为自监督图学习 (Self-supervised Graph Learning : SGL),并在SOTA的模型LightGCN上实现它。通过理论分析,我们发现SGL具有自动挖掘hard negatives的能力。在三个基准数据集上进行的实证研究证明了SGL的有效性,它提高了推荐准确率(尤其是长尾items的推荐准确率),以及对interaction noises的鲁棒性。我们的实现可在https://github.com/wujcan/SGL上找到。从交互数据中学习高质量的

user and item representations是协同推荐的核心。早期的矩阵分解(matrix factorization: MF)等方法将每个用户(或item)的单一ID映射到一个embedding向量中。后续一些研究通过结合interaction history来丰富单一ID,以学习更好的representations。最近,representation learning已发展到利用user-item graph中的高阶连接性(higher-order connectivity)。该技术受图卷积网络(graph convolution network: GCN)的启发,GCN提供了一种端到端的方式,将multi-hop neighbors的信息集成到node representation learning中,并在推荐任务中取得了SOTA的性能。尽管

GCN-based的推荐模型取得了不错的效果,但它们仍存在一些局限性:监督信号稀疏:大多数模型在监督学习范式下处理推荐任务,监督信号来自观察到的

user-item interactions。然而,与整个interactions空间相比,观察到的interactions极其稀疏,不足以学到高质量的representations。数据分布不均衡:观察到的

interactions通常呈现幂律分布,长尾部分由缺乏监督信号的low-degree items组成。相比之下,high-degree items在neighborhood aggregation和supervised loss中出现得更为频繁,对representation learning的影响更大。因此,GCN容易偏向high-degree items,牺牲low-degree (long-tail) items的性能。interactions中的噪声:用户提供的大多数反馈是隐式的(例如点击、浏览),而非显式的(例如评分、喜欢 / 不喜欢)。因此,观察到的interactions通常包含噪声,例如用户可能被误导点击某个item,但使用后发现并不感兴趣。GCN中的neighborhood aggregation机制放大了interactions对representation learning的影响,使得学习过程更容易受到interaction noises的干扰。

在这项工作中,我们专注于在推荐任务中探索自监督学习(

self-supervised learning: SSL),以解决上述局限性。尽管自监督学习在计算机视觉和自然语言处理中已得到广泛应用,但在推荐领域的探索相对较少。其核心思想是设置一个辅助任务,从输入数据本身提取额外的信号,特别是通过利用unlabeled data space。例如:BERT会随机掩码句子中的一些tokens,把prediction of the masked tokens作为辅助任务,以此捕获tokens之间的依赖关系。RotNet随机旋转labeled images,在旋转后的图像上训练模型,以获得improved representations从而用于物体识别(object recognition)或图像分类。

与监督学习相比,自监督学习允许我们通过对输入数据进行变换来利用

unlabeled data space,从而在下游任务中取得显著改进 。在这里,我们希望将自监督学习的优势引入

recommendation representation learning中。由于推荐数据具有离散的且相互连接的特点,这与计算机视觉和自然语言处理任务有所不同。为了解决GCN-based的推荐模型的上述局限性,我们构建了一个辅助任务,即区分节点自身的representation。具体来说,它包含两个关键组件:(1):数据增强,为每个节点生成多个视图。(2):对比学习,最大化同一节点的不同视图之间的一致性,同时最小化与其他节点视图之间的一致性。

对于

user-item graph上的GCN,图结构作为输入数据,在representation learning中起着至关重要的作用。从这个角度出发,通过改变图邻接矩阵(graph adjacency matrix)来构建"unlabeled" data space是很自然的想法,为此我们开发了三种算子:node dropout、edge dropout和random walk,每个算子都有不同的原理。然后,我们在改变后的图结构上基于GCN进行对比学习。结果,自监督图学习(SGL)通过探索节点之间的内部关系增强了node representation learning。从概念上讲,我们的

SGL在以下几个方面对现有的GCN-based的推荐模型进行了补充:(1):node self-discrimination提供了辅助监督信号,与仅从observed interactions中获得的经典的监督信号互补。(2):augmentation算子(尤其是edge dropout),通过有意减少high-degree nodes的影响,有助于减轻degree biases。(3):针对不同局部结构和邻居的multiple views for nodes增强了模型对interaction noises的鲁棒性。

最后,我们对对比学习范式进行了理论分析,发现它具有挖掘

hard negative examples的副作用,这不仅提高了性能,还加速了训练过程。值得一提的是,我们的

SGL是模型无关的,可以应用于任何包含user and/or item embedding的graph-based model。在这里,我们在简单而有效的LightGCN模型上实现了SGL。在三个基准数据集上的实验研究证明了SGL的有效性,它显著提高了推荐准确率,尤其是对long-tail items的推荐准确率,并增强了模型对interaction noises的鲁棒性。我们总结这项工作的贡献如下:我们设计了一种新的学习范式

SGL,将node self-discrimination作为自监督任务,为representation learning提供辅助信号。除了减轻

degree bias和提高对interaction noises的鲁棒性之外,我们从理论上证明了SGL本质上鼓励从hard negatives中学习,这一过程由softmax损失函数中的温度超参数控制。我们在三个基准数据集上进行了广泛的实验,以证明

SGL的优越性。

1.1 预备知识

我们首先总结

GCN-based协同过滤模型的常见范式。设items集合。设observed interactions,其中itemitems,边集合observed interactions。回顾

GCN:GCN的核心是在图上应用neighborhood aggregation方案,通过聚合邻居节点的representations来更新中心节点的representation:其中:

node representations,node representations,ID embeddings(可训练的参数)。neighborhood aggregation的参数,从向量层面来看更具解释性:

为了更新中心节点

representation,它首先聚合其邻居representations,然后与自身在第representation相结合。对于representations编码了图中的在获得

representations后,可能会有一个readout函数final representations用于预测:监督学习的损失:

prediction layer构建在final representations之上,以预测用户item为了优化模型参数,现有工作通常将该任务构建为一种监督学习任务,监督信号来自

observed interactions(也是图missing data中选择负样本。除了上述

point-wise learning,另一种常见的选择是pairwise的Bayesian Personalized Ranking: BPR损失,它强制要求observed interaction的预测得分高于unobserved interaction:其中:

unobserved interactions。在这项工作中,我们选择它作为主体的监督任务。

1.2 方法

我们提出了自监督图学习(

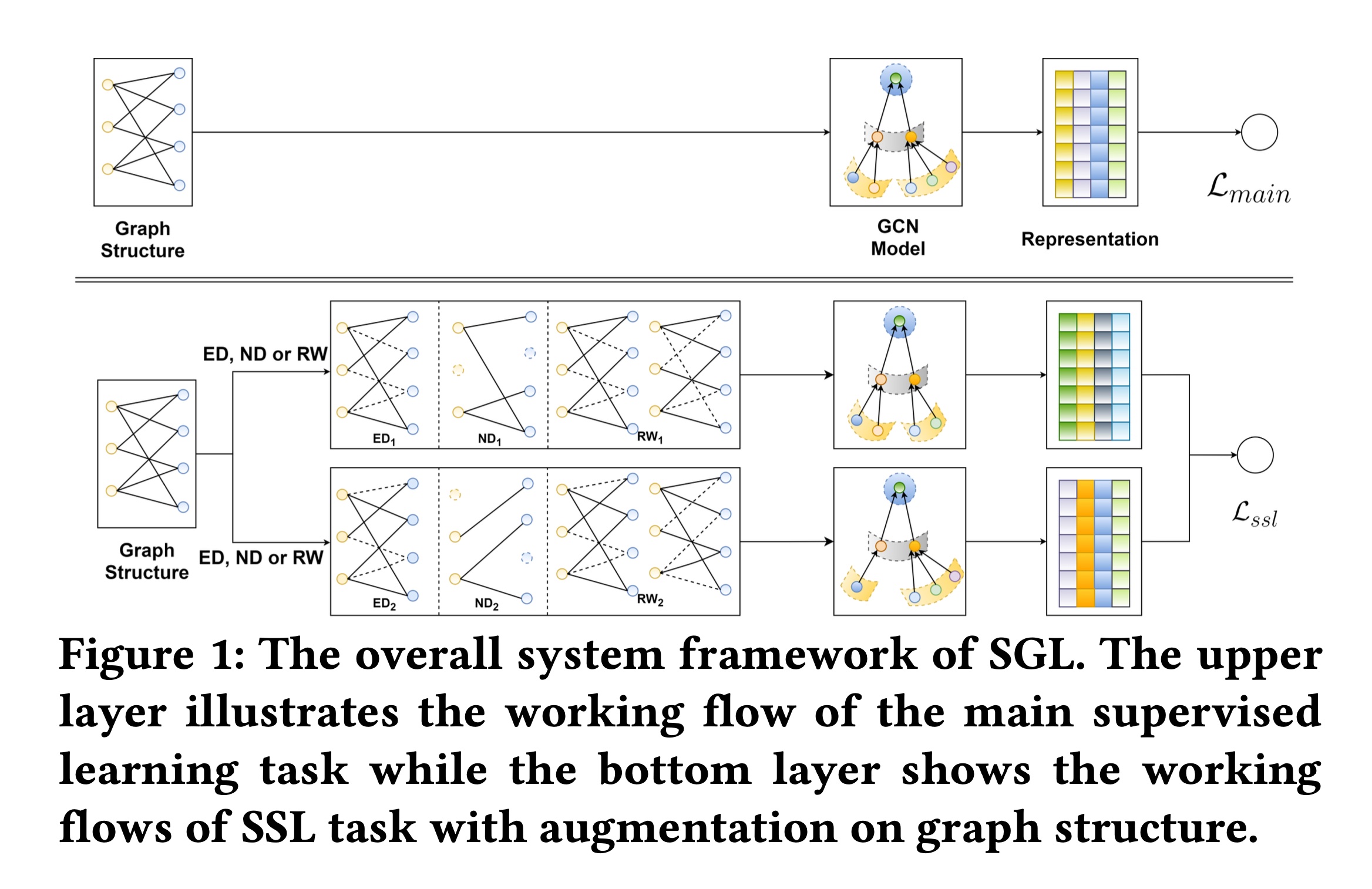

Self-supervised Graph Learning: SGL)范式,它通过自监督学习增强了主体的监督任务。Figure 1展示了SGL的工作流程。具体来说,自监督任务(也称为前置任务或辅助任务)是从输入数据的相关性中构建监督信号。具体来说,我们介绍如何进行数据增强以生成多个

representation视图,然后基于所生成的representations进行对比学习以构建辅助任务。SSL与经典GCN以多任务学习的方式相结合。 随后,我们从梯度层面对SSL进行理论分析,揭示其与hard negative mining的联系。 最后,我们分析了SGL的复杂性。

1.2.1 图结构上的数据增强

直接将计算机视觉和自然语言处理任务中采用的数据增强方法应用于

graph-based recommendation是不可行的,这是由于其特定的特性:(1):用户和items的特征是离散的,如one-hot ID和其他categorical的变量。因此,图像上的增强操作,如随机裁剪、旋转或模糊,并不适用。(2):更重要的是,与计算机视觉和自然语言处理任务将每个数据实例视为孤立的不同,interaction graph中的用户和items本质上是相互连接和依赖的。

因此,我们需要为

graph-based recommendation量身定制新的增强算子(augmentation operators)。二部图是基于观察到的

user-item interactions来构建的,因此包含协同过滤信号。具体来说:一阶邻居直接描述了用户节点和

items节点的特性,即用户的historical items(或item的interacted users)可以视为用户(或item)的pre-existing特征。用户(或

item)的二阶邻居节点展示了行为相似的用户(或受众相似的item)。此外,从用户到

item的高阶路径反映了用户对该item的潜在兴趣。

毫无疑问,挖掘图结构中的固有模式有助于

representation learning。因此,我们在图结构上设计了三种算子:node dropout、edge dropout和random walk,以创建节点的不同视图。这些算子可以统一表示为:其中两个随机选择

augmentation operators如下:Node Dropout (ND):以概率其中:

masking vectors,用于生成两个子图。这样,这种数据增强有望从不同augmented views中识别出有影响力的节点,并使representation learning对结构变化不那么敏感。实验章节提到,

ND是一种特殊类型的ED:将选中节点的周围的所有边移除。并且实验发现:ND的性能不如ED。Edge Dropout (ED):以dropout rate其中:

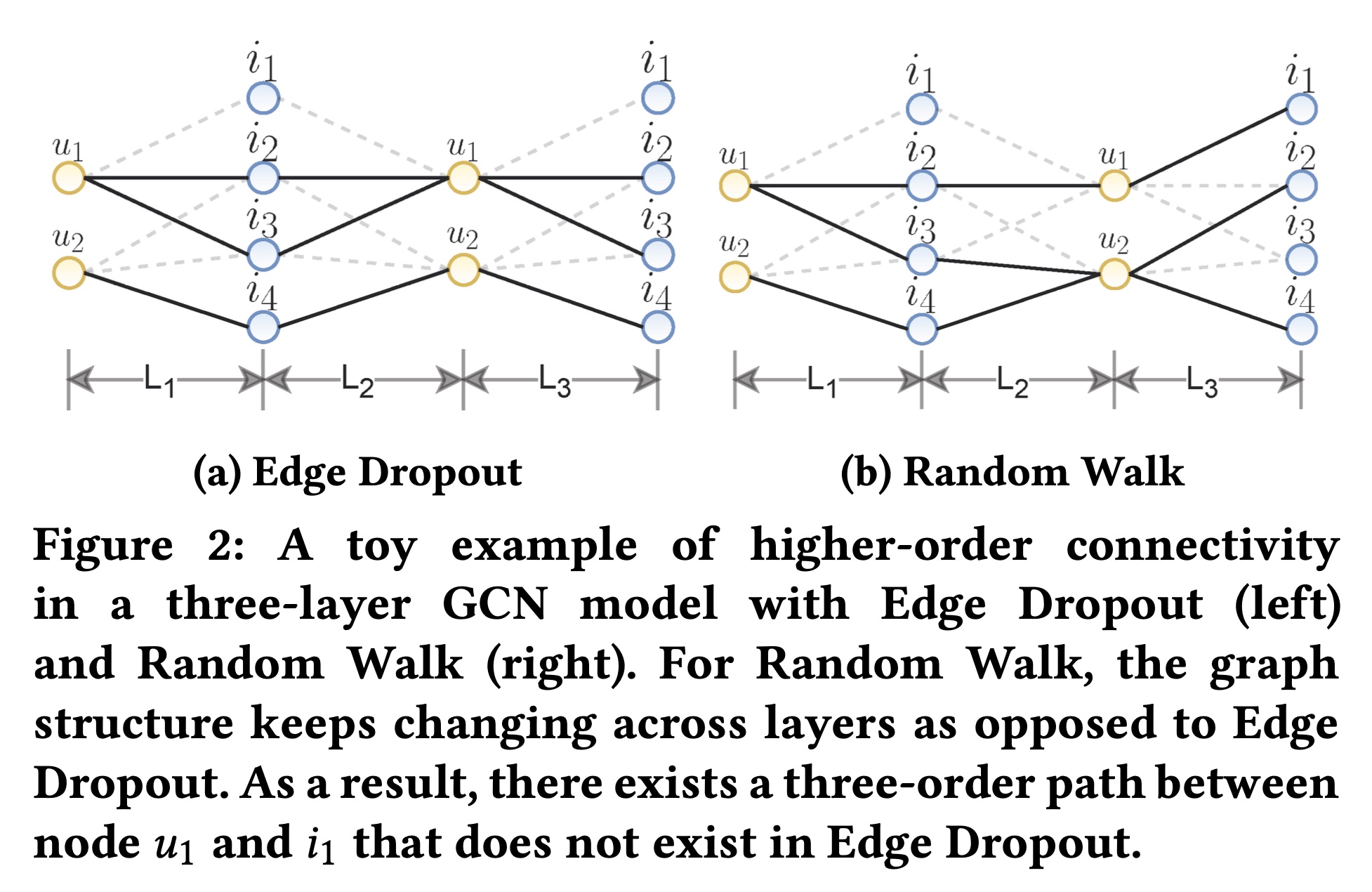

masking vectors。只有邻居内的部分连接对node representations有贡献。因此,将这两个子图耦合在一起旨在捕获节点局部结构的有用模式,并进一步使representations对noisy interactions更具鲁棒性。Random Walk (RW):上述两种算子生成的子图在所有图卷积层(graph convolution layers)中共享。为了探索更高的能力,我们考虑为不同层分配不同的子图。这可以看作是通过随机游走为每个节点构建一个单独的子图(见Figure 2的示例)。假设我们在每一层选择edge dropout(具有不同的比率或随机数种子),我们可以通过使masking vector对层敏感来公式化随机游走:其中:

masking vectors。

为了简单起见,我们在每个

epoch对图结构应用这些增强操作。也就是说,我们在新的training epoch开始时为每个节点生成两个不同的视图(对于随机游走,为每个节点在每一层生成两个不同的视图)。注意,两个独立过程(即更复杂的操作是:为每个

training batch生成不同的视图。更简单的操作是:生成一组视图,然后在整个训练过程中(跨所有

epoch)共享。注意:根据论文的实验章节描述,不能混合这三种数据增强操作。也就是说,在整个训练过程中,要么选择

ND、要么选择ED、要么选择RW。

1.2.2 对比学习

在建立了节点的

augmented views之后,我们将同一节点的不同视图视为positive pairs(即negative pairs(即positive pairs的auxiliary supervision鼓励同一节点的不同视图在预测时的一致性。而

negative pairs的auxiliary supervision则强制不同节点之间的差异。

正式地,我们遵循

SimCLR并采用对比损失(即,InfoNCE)以最大化positive pairs的一致性并最小化negative pairs的一致性:其中:

softmax中称为温度。

类似地,我们得到

item侧的对比损失实验章节表明:可以采用

in-batch负样本来代替全局负样本,这会带来性能的略微下降。

1.2.3 多任务训练

为了通过自监督学习任务改进

recommendation,我们采用多任务训练策略,联合优化经典推荐任务(即,其中:

L2正则化的强度。

我们还考虑了交替优化:先在

实验章节表明:“预训练 --> 微调” 的方式能够带来增益,但是效果不如联合训练。

1.2.4 SGL 的理论分析

在本节中,我们对

SGL进行深入分析,旨在回答以下问题:推荐模型如何从自监督学习任务中受益?为此,我们探究公式hard negative mining的固有能力,这为优化过程贡献了大且有意义的梯度,并指导node representation learning。接下来,我们逐步进行分析。正式地,对于节点

representation其中:

negative view。positive nodenegative node其中:

normalized representations。节点

之后,我们关注

negative node由于

其中

positive nodenegative noderepresentation similarity。根据相似性,我们可以大致将negative节点分为两组:(1):hard negative nodes,它们的representations与positive noderepresentation相似(即,(2):easy negative nodes,它们的representations与positive noderepresentation不相似(即,

为了研究

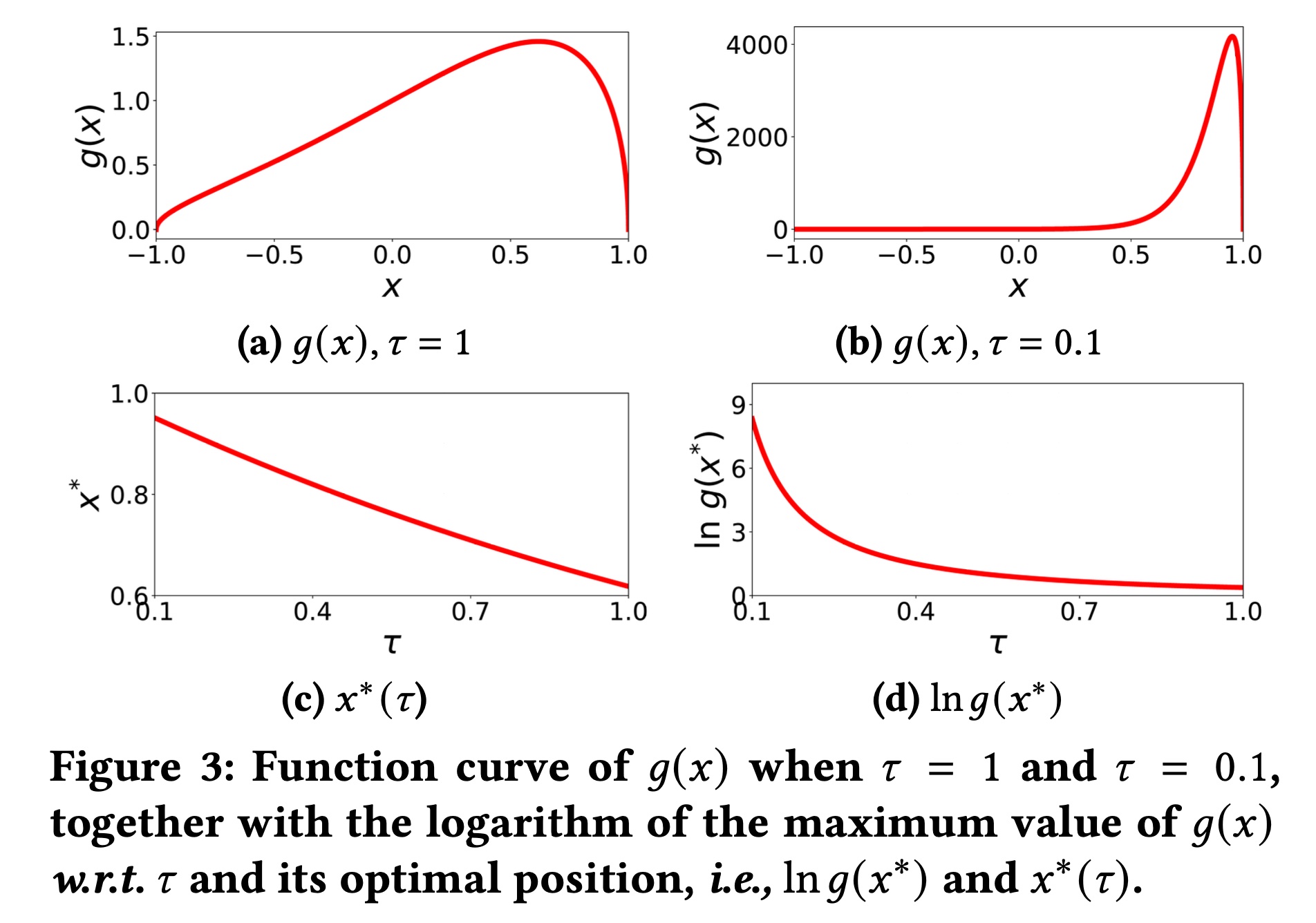

hard negatives和easy negatives的贡献,我们分别设置Figure 3a和3b所示。显然,在不同的条件下,negative节点的贡献差异很大。具体来说:如

Figure 3a所示,当hard负样本还是easy负样本,对梯度的贡献相似。相比之下,如

Figure 3b所示,当设置hard负样本的4000,而easy负样本的贡献几乎为零。这表明hard负样本节点提供了更大的梯度来指导优化,从而使node representations更具区分性,并加速训练过程。

这些发现启发我们探究

此时

我们分别在

Figure 3c和3d中展示0.9);此外,最具影响力的负节点的贡献呈超指数放大(即SGL自动执行hard negative mining。即,通过选择一个较小的

hard negative样本的梯度呈现较大的贡献,即 “自动执行hard negative mining”。实验章节表明:可以通过超参数调优来选择合适的

值得一提的是,我们的分析受到先前研究

《Supervised Contrastive Learning》的启发,但存在主要差异:(1):《Supervised Contrastive Learning》将hard负样本定义为与正样本相似度接近零的样本(即easy负样本定义为明显不相似的样本(即(2)它没有涉及的区域softmax中的温度超参数hard负样本中的关键作用。

1.2.5 SGL 的复杂度分析

在本小节中,我们以

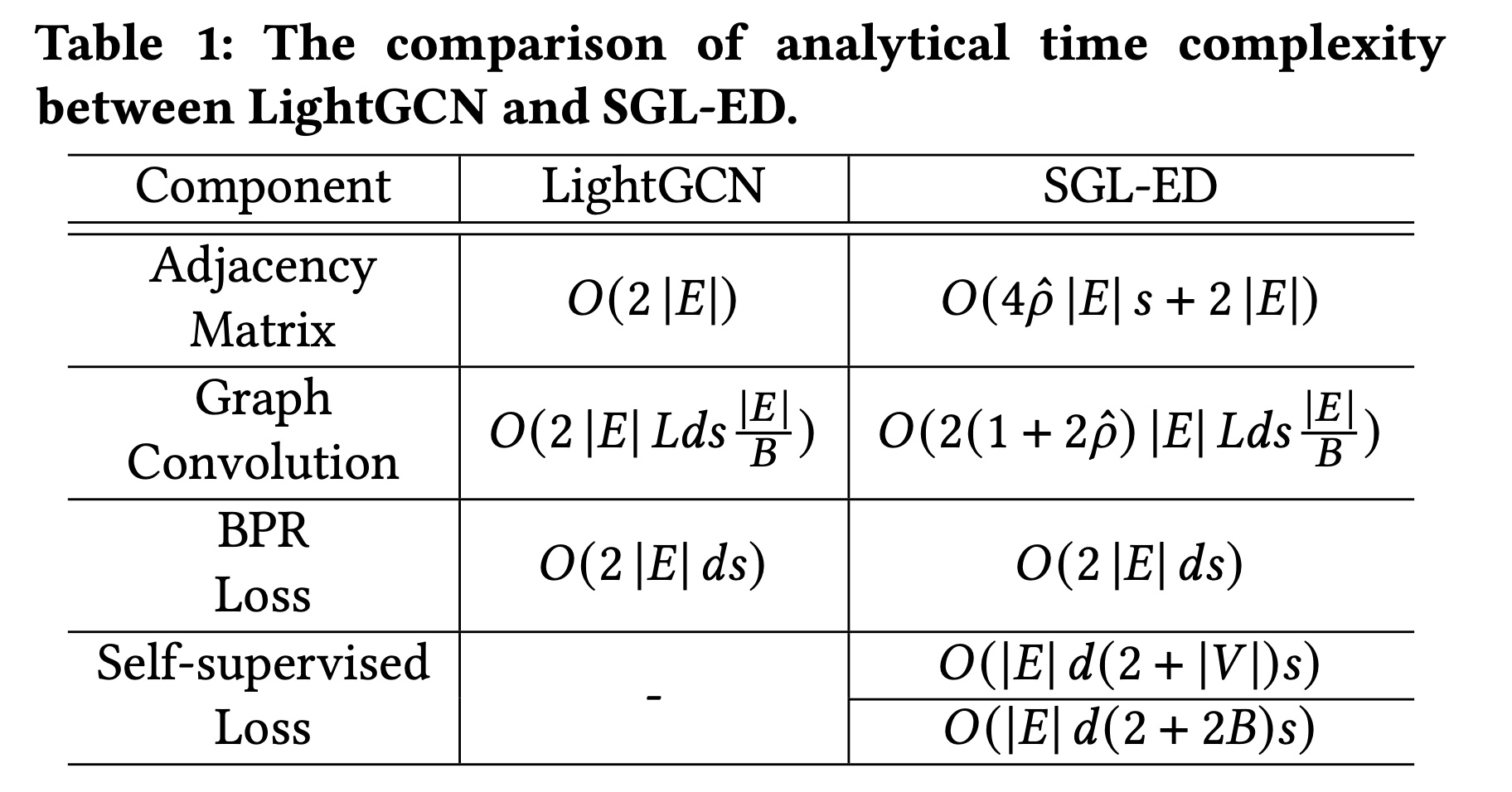

Edge Dropout: ED为策略、LightGCN为推荐模型来分析SGL的复杂度;其他策略的分析方式类似。由于SGL不引入可训练参数,其空间复杂度与LightGCN相同。模型推理的时间复杂度也相同,因为模型结构没有变化。在以下部分,我们将分析SGL训练的时间复杂度。假设

user-item interaction graph中的节点数和边数分别为epochs,batch的大小,embedding维度,GCN层数,SGL-ED的保留概率(keep probability)。复杂度主要来自两个部分:邻接矩阵的归一化:由于我们每个训练

epoch生成两个独立的子图,考虑到完整训练图和两个子图的邻接矩阵中的非零元素数量分别为评估自监督损失:在分析中我们仅考虑内积。如公式

InfoNCE损失时,我们将所有其他用户节点视为负样本。在一个batch内,分子和分母的复杂度分别为epoch中,用户侧和item侧的总复杂度为一种降低时间复杂度的替代方法是仅将

batch内的用户(或items)视为负样本,这样总时间复杂度为通常

我们在

Table 1中总结了LightGCN和SGL-ED在训练时的时间复杂度。实际上,LightGCN和SGL-ED的分析复杂度处于同一数量级,因为SGL-ED的复杂度增加只是对LightGCN复杂度的一个缩放。在实践中,以Yelp2018数据为例,SGL-ED(替代方法)的时间复杂度约为LightGCN的3.7倍,考虑到我们将在实验章节中展示的收敛速度的提升,这是完全可以接受的。测试平台是配备英特尔i7 - 9700K CPU、32GB内存、以及英伟达Titan RTX显卡。在Yelp2018上,LightGCN和SGL-ED(替代方法)每epoch的时间成本分别为15.2秒和60.6秒,这与复杂度分析结果一致。这里时间成本差异不大的核心原因是:数据集太小。对于十亿级别的数据集,

SGL的复杂度太高,难以承受。

1.3 实验

为了证明

SGL的优越性并揭示其有效性的原因,我们进行了广泛的实验,并回答以下研究问题:RQ1:与SOTA的协同过滤模型相比,SGL在top-K recommendation方面表现如何?RQ2:在协同过滤中进行自监督学习有哪些好处?RQ3:不同的设置如何影响所提出的SGL的有效性?

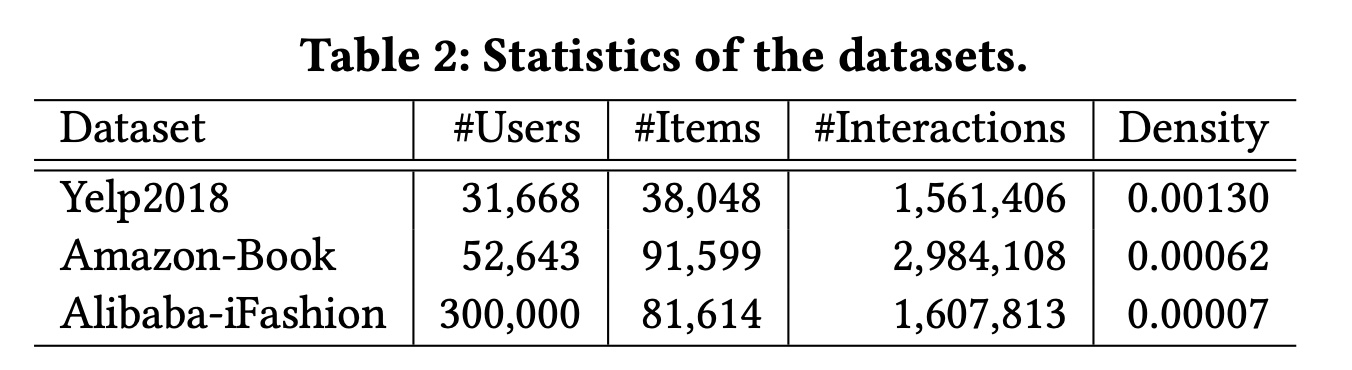

数据集:我们在三个基准数据集上进行实验:

Yelp2018、Amazon - Book和Alibaba - iFashion。遵循

《LightGCN: Simplifying and Powering Graph Convolution Network for Recommendation》、《Neural Graph Collaborative Filtering》,我们对Yelp2018和Amazon - Book使用相同的10-core setting。Alibaba - iFashion数据集更为稀疏,我们从中随机抽取30万用户,并使用他们在时尚服装上的所有交互数据。三个数据集的统计信息总结在

Table 2中。我们遵循

《Neural Graph Collaborative Filtering》中描述的相同策略,将交互数据按照7 : 1 : 2的比例划分为训练集、验证集和测试集。对于测试集中的用户,我们遵循all-ranking协议 (《Neural Graph Collaborative Filtering》)来评估top-K推荐性能,并报告平均Recall@K和NDCG@K,其中这是按照

interactions来划分的,而不是按照用户来划分的。

基线方法:我们将所提出的

SGL与以下协同过滤模型进行比较:NGCF(《Neural Graph Collaborative Filtering》):这是一种基于图的协同过滤方法,在很大程度上遵循标准的GCN。它在消息传递过程中额外将二阶feature interaction编码到message中。我们在建议的范围内调优正则化系数GCN层数。LightGCN:该方法设计了一种轻量级图卷积,以提高训练效率和generation能力。同样,我们调优GCN层数。Mult-VAE:这是一种基于变分自编码器(variational auto-encoder: VAE)的item-based的协同过滤方法。它通过额外的reconstruction目标进行优化,这可以看作是自监督学习的一种特殊情况。我们遵循建议的模型设置,并调优droupout rate和DNN + SSL(《Self-supervised Learning for Deep Models in Recommendations》):这是一种SOTA的基于自监督学习的推荐方法。以DNN作为items的编码器,它对items的pre-existing features采用两种增强算子:即,特征掩码(feature masking: FM)和特征丢弃(feature dropout: FD)。在我们没有item feature可用的情况下,我们将这些增强操作应用于items的ID embeddings。我们按照原始论文中的建议调优DNN架构(即层数和每层的神经元数量)。

我们舍弃了像

MF、NeuMF、GCMC和PinSage等潜在的基线模型,因为先前的工作已经验证了这些基线模型的效果不佳。在LightGCN的基础上,我们实现了所提出的SGL的三个变体,分别命名为SGL-ND、SGL-ED和SGL-RW,它们分别配备了Node Dropout、Edge Dropout和Random Walk。超参数设置:

为了进行公平比较,所有模型均从头开始训练,使用

Xavier方法进行初始化。模型由

Adam优化器进行优化,学习率为0.001,batch size为2048。早停策略与

NGCF和LightGCN相同。所提出的

SGL方法继承了共享超参数的最优值。对于SGL特有的超参数,我们在{0.005, 0.01, 0.05, 0.1, 0.5, 1.0}、{0.1, 0.2, 0.5, 1.0}和{0, 0.1, 0.2, 0.3, 0.4 , 0.5}范围内分别调优

1.3.1 性能比较(RQ1)

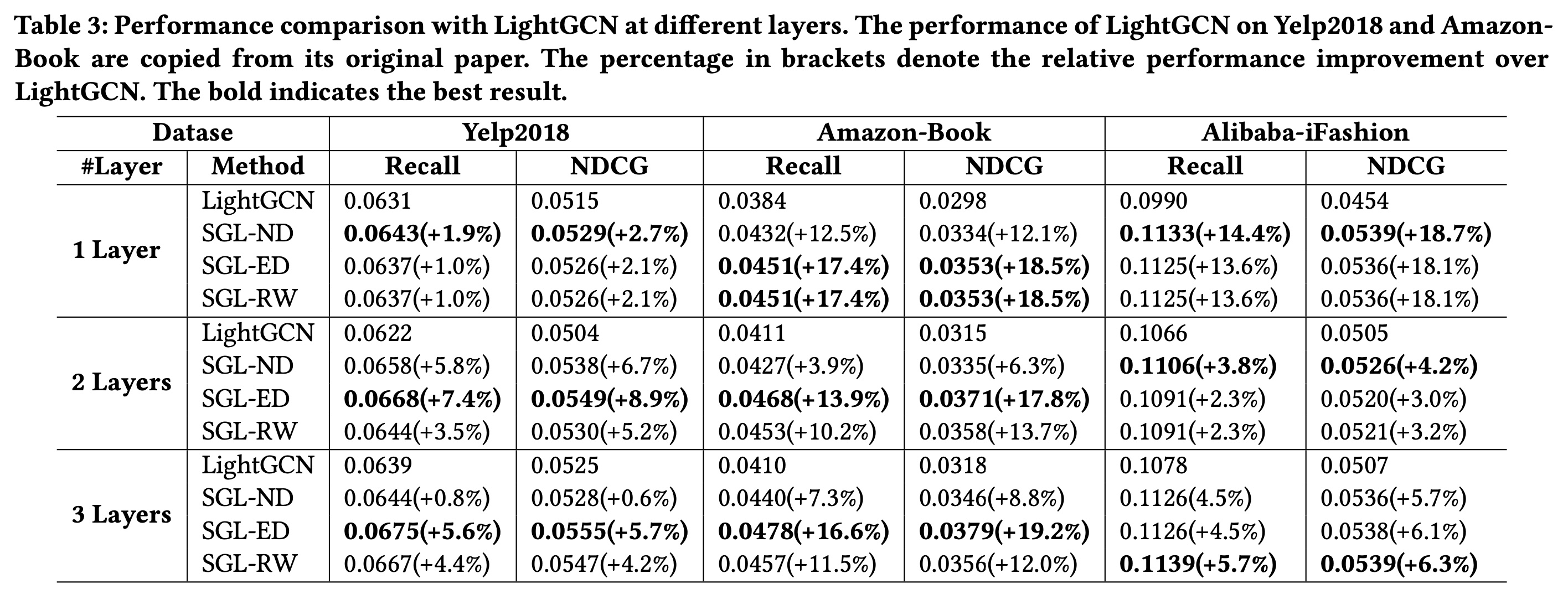

与

LightGCN的比较:Table 3展示了SGL和LightGCN之间的结果比较。我们发现:在大多数情况下,

SGL的三种实现方式在很大程度上优于LightGCN,这表明用自监督学习补充推荐任务的优越性。在

SGL系列中,SGL-ED在18种情况中的10种情况下表现最佳,而SGL-RW在所有三个数据集上的表现也优于SGL-ND。我们将其归因于类似edge dropout的算子在捕获图结构中固有模式的能力。此外,

SGL-ED在密度较高的数据集(Yelp2018和Amazon-Book)上的性能优于SGL-RW,而在较稀疏的数据集(Alibaba - iFashion)上略逊一筹。一个可能的原因是,在稀疏数据集中,Edget Dropout更有可能阻碍low-degree节点(不活跃用户和不受欢迎的items)的连接,而随机游走可以在不同layers中恢复它们的连接,如Figure 2中节点SGL-ND比SGL-ED和SGL-RW相对不稳定。例如,在Yelp2018和Amazon-Book上,SGL-ED和SGL-RW的结果随着层数的增加而提升,而SGL-ND呈现出不同的模式。Node Dropout可以看作是Edge Dropout的一种特殊情况,它丢弃了少量节点周围的所有边。因此,丢弃high-degree节点会极大地改变图结构,从而影响information aggregation,并使训练不稳定在

Amazon-Book和Alibaba-iFashion上的改进比在Yelp2018上更为显著。这可能是由数据集的特性造成的。具体来说,在Amazon-Book和Alibaba-iFashion中,来自user-item interactions的监督信号过于稀疏,无法在LightGCN中指导representation learning。受益于自监督任务,SGL获得了辅助监督来帮助representation learning。将模型深度从

1增加到3能够提升SGL的性能。这表明利用自监督学习可以增强GCN-based的推荐模型的泛化能力。也就是说,不同节点之间的对比学习有望解决node representations的过平滑问题(oversmoothing issue),进一步避免过拟合问题。

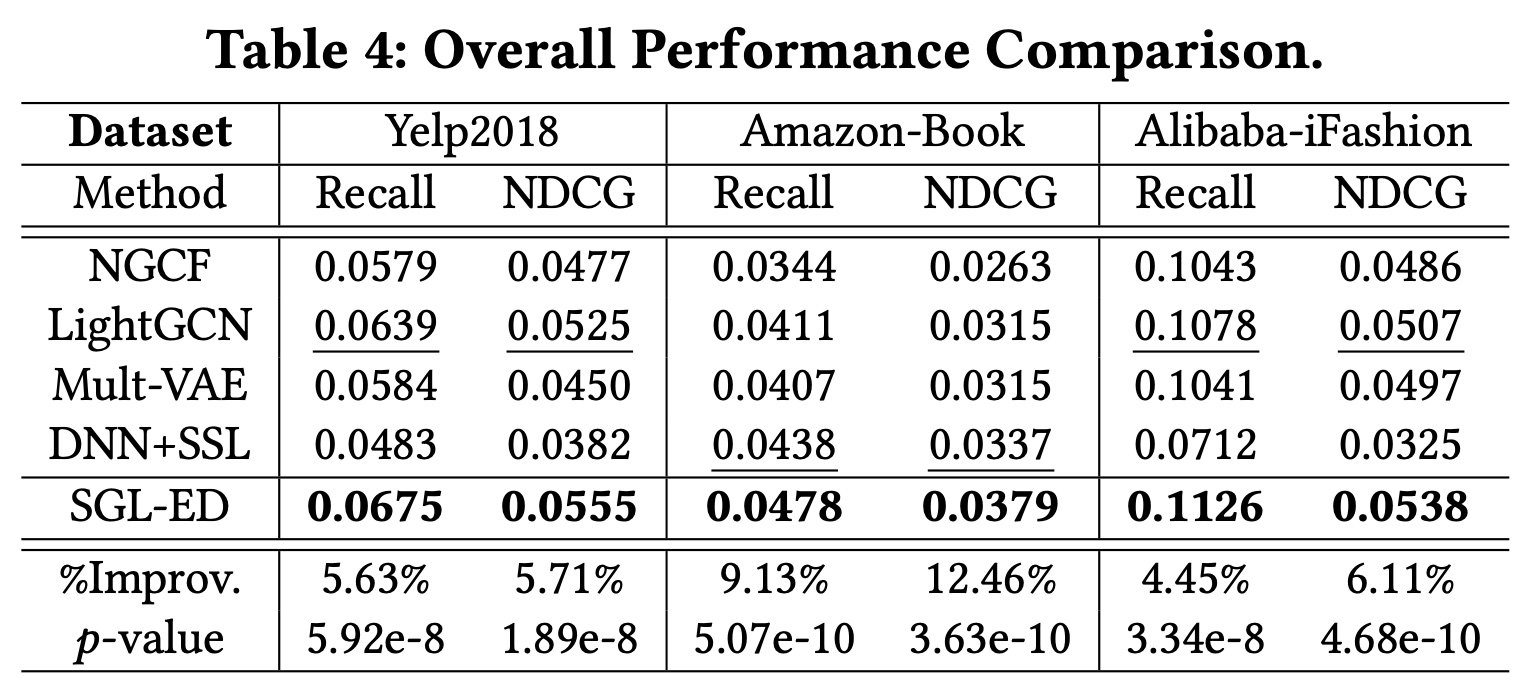

与

SOTA模型的比较:在Table 4中,我们总结了与各种基线模型的性能比较。我们发现:(1):SGL-ED在所有指标上始终优于所有基线模型。这再次验证了结合自监督学习的合理性和有效性。(2):LightGCN的性能优于NGCF和Mult-VAE,这与LightGCN论文中的主张一致。Mult-VAE在Alibaba-iFashion上的性能与NGCF和LightGCN相当,而在Amazon-Book上优于NGCF。(3):DNN + SSL是Amazon-Book上最强的基线模型,显示出自监督学习在推荐中的巨大潜力。令人惊讶的是,在其他数据集上,DNN + SSL的表现比SGL-ED差得多。这表明直接在ID embedding上应用自监督学习可能不是最优的,比在graph representation应用自监督学习要差。(4):此外,我们进行了显著性检验,SGL-ED相对于最强基线模型的改进在所有六种情况下在统计上都是显著的。

1.3.2 SGL 的优势(RQ2)

在本节中,我们从三个维度研究

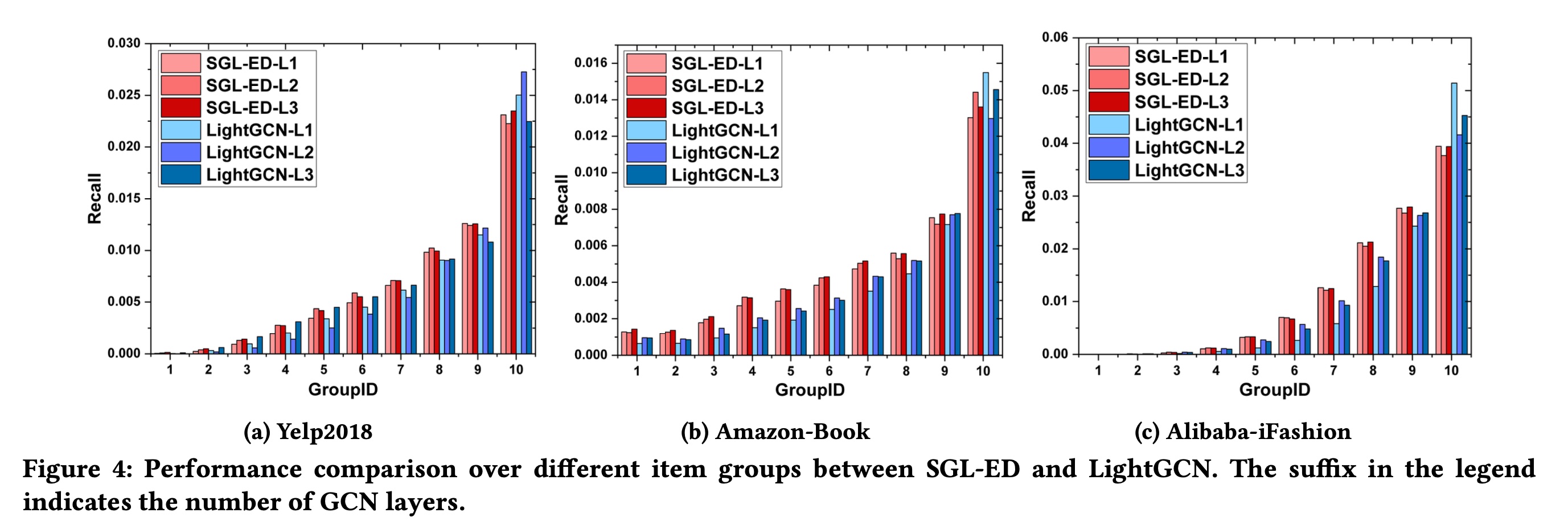

SGL的优势:长尾推荐、训练效率、对噪声的鲁棒性。由于篇幅有限,我们仅报告SGL-ED的结果,其他变体也有类似的观察结果。长尾推荐:如引言所述,

GNN-based的推荐模型很容易受到长尾问题的影响。为了验证SGL是否有望解决这个问题,我们根据items的流行度将items分为十组,同时保持每组的interactions总数相同。GroupID越大,items的degrees越大。然后,我们将整个数据集的Recall@20指标分解为单个组的贡献,如下所示:其中:

top-K recommendation list中的items、以及测试集中的relevant items(即,ground-truth)。因此,Figure 4中报告结果,发现:LightGCN倾向于推荐high-degree items,而使长尾items的曝光较少。具体来说,在三个数据集中,尽管第10组仅包含item spaces的0.83%、0.83%和0.22%,但该组分别贡献了总Recall得分的39.72%、39.92%和51.92%。这表明,由于interaction信号的稀疏,LightGCN很难学习到长尾items的高质量representations。我们的

SGL在缓解这个问题方面显示出潜力:在三个数据集中,第10组的贡献分别下降到36.27%、29.15%和35.07%。结合

Table 3和Figure 4进行分析,我们发现SGL的性能提升主要来自于对sparse interactions的items的准确推荐。这再次验证了representation learning从辅助监督中受益匪浅,从而能够比LightGCN更好地建立这些items的representations。

训练效率:自监督学习已在预训练自然语言模型和预训练图结构中证明了其优越性。因此,我们研究它对训练效率的影响。

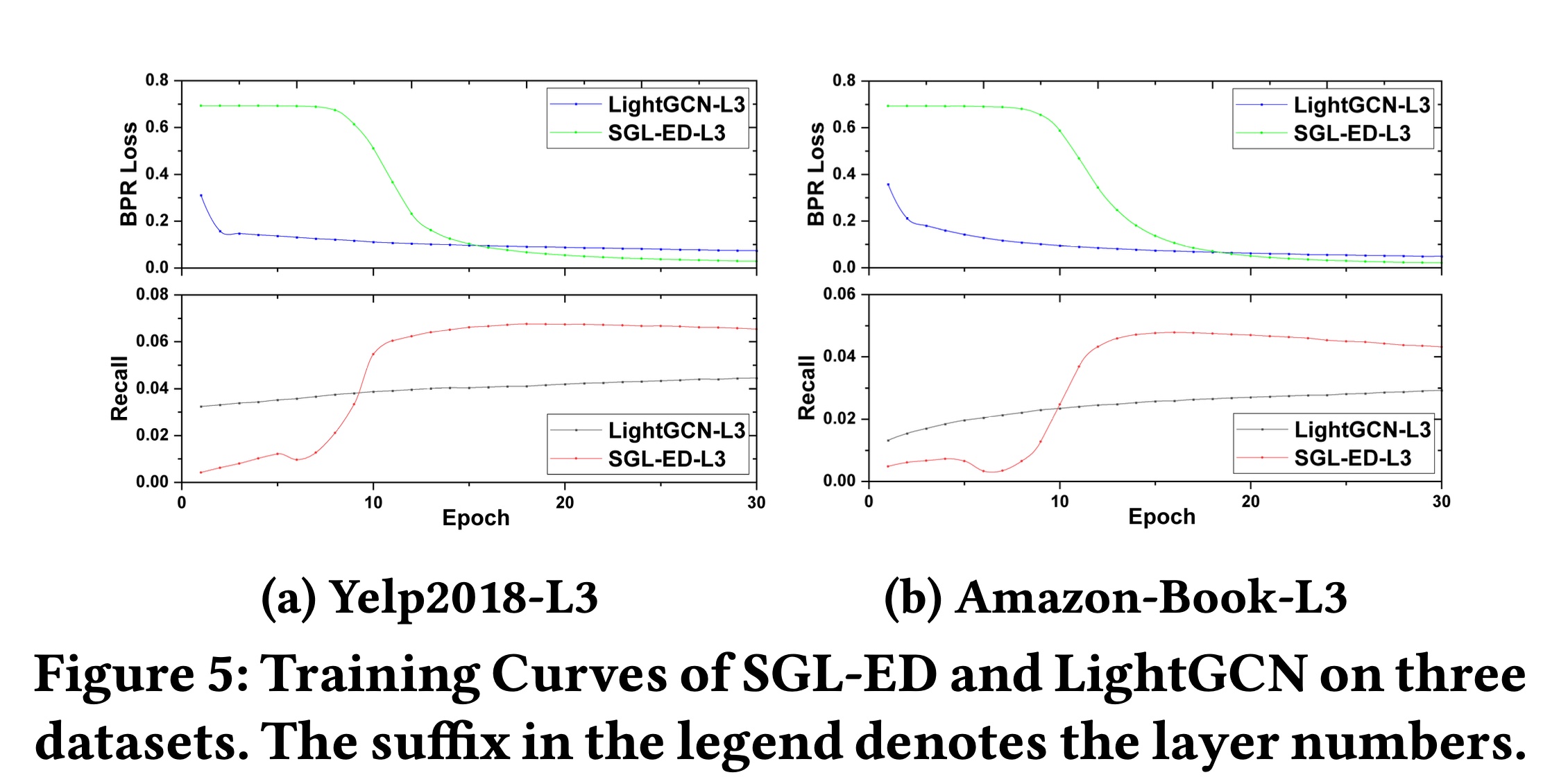

Figure 5展示了SGL-ED和LightGCN在Yelp2018和Amazon-Book数据集上的训练曲线。随着训练epochs增加,上图显示training loss的变化,下图记录测试集上的性能变化。我们有以下发现:显然,在

Yelp2018和Amazon-Book数据集上,SGL的收敛速度比LightGCN快得多。具体来说,SGL在第18 epochs和第16 epochs达到最佳性能,而LightGCN在这两个数据集上分别需要720 epochs和700 epochs。这表明我们的SGL可以大大减少训练时间,同时取得显著的性能提升。我们将这种加速归因于两个因素:(1):SGL采用InfoNCE loss作为自监督学习目标,使模型能够从多个负样本中学习representations,而LightGCN中的BPR loss只使用一个负样本,限制了模型的感知范围。(2):如前所述,通过适当设置SGL受益于动态的hard negative mining,hard负样本提供有意义且更大的梯度来指导optimization。

另一个发现是,

BPR loss快速下降期的起点略晚于Recall快速上升期。这表明BPR loss和ranking任务之间存在差距。我们将在未来的工作中对这一现象进行深入研究。

对

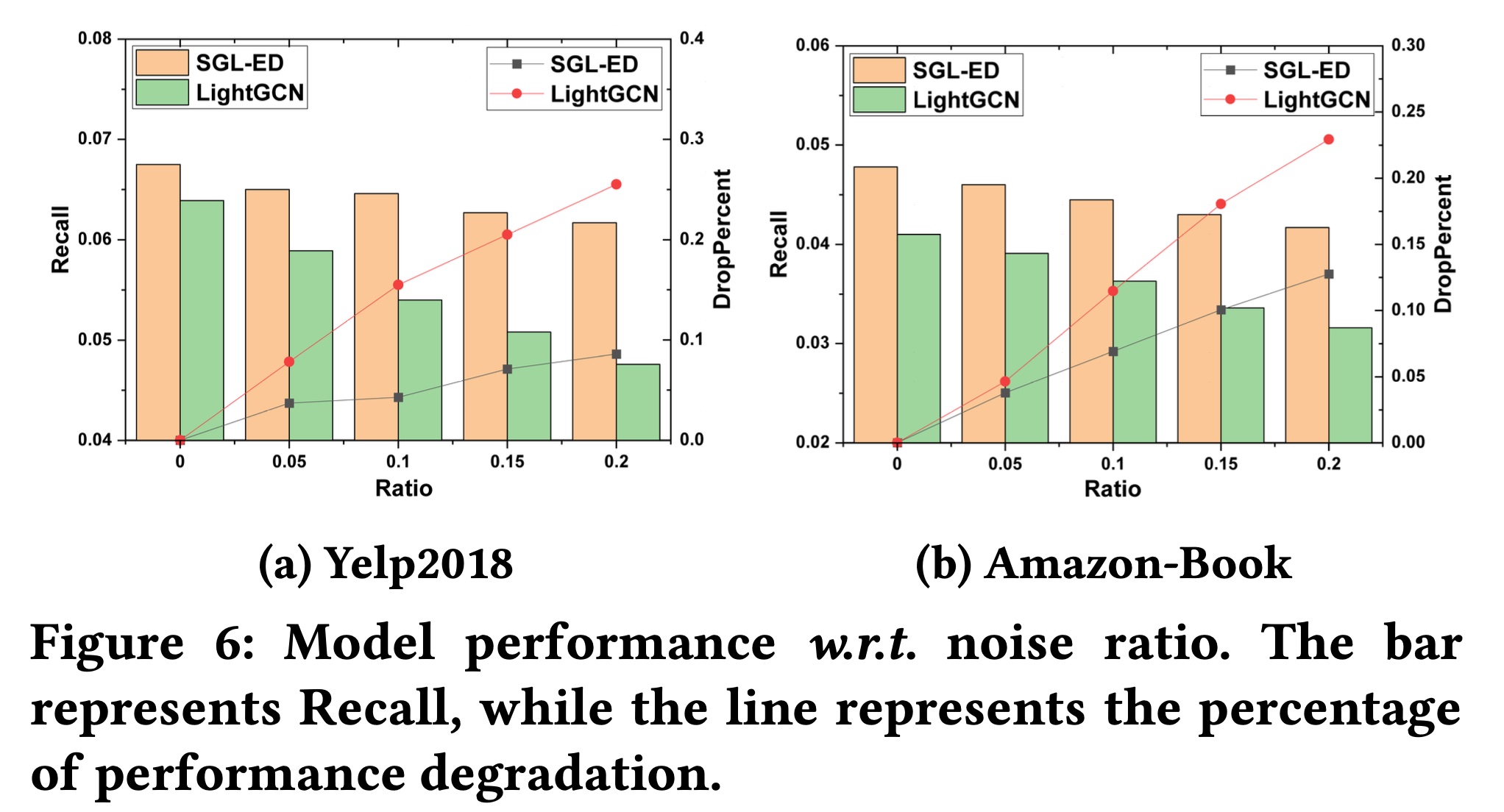

Noisy Interactions的鲁棒性:我们还进行实验来检验SGL对noisy interactions的鲁棒性。为此,我们在训练集中添加一定比例的对抗性的样本(即5%、10%、15%、20%的negative user-item interactions)来污染训练集,同时保持测试集不变。Figure 6展示了在Yelp2018和Amazon-Book数据集上的结果。显然,添加

noise data会降低SGL和LightGCN的性能。然而,SGL的性能下降幅度低于LightGCN;此外,随着噪声比例增加,两条性能下降曲线之间的差距变得更加明显。这表明,通过比较节点的不同增强的视图,SGL能够找出有用的模式,特别是节点的informative的图结构,并减少对某些边的依赖。简而言之,SGL为消除推荐中false positive interactions的噪声提供了不同的视角。聚焦于

Amazon-Book数据集,添加20%额外noisy interactions的SGL性能仍优于无噪声数据集上的LightGCN。这进一步证明了SGL相对于LightGCN的优越性和鲁棒性。我们发现

SGL在Yelp2018数据集上更鲁棒。可能的原因是Amazon-Book数据集比Yelp2018稀疏得多,添加噪声数据对Amazon-Book图结构的影响比Yelp2018更大。

1.3.3 对 SGL 的研究(RQ3)

我们继续研究

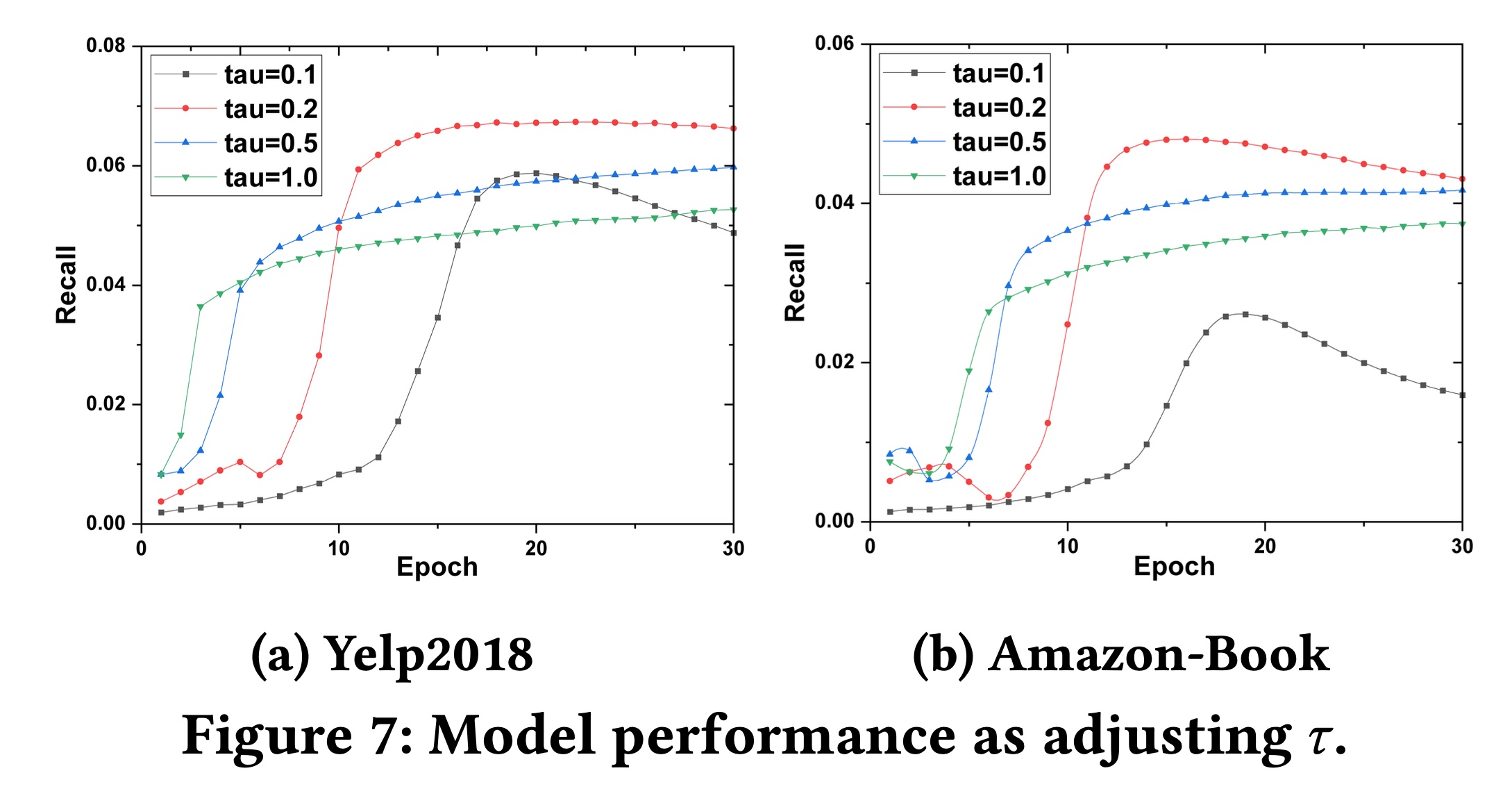

SGL中的不同设计。首先研究超参数SGL用作现有graph-based的推荐模型的预训练的潜力,最后研究自监督学习目标函数中负样本选择的影响。由于篇幅限制,我们省略了iFashion数据集上的结果,其趋势与Yelp2018和Amazon-Book数据集相似。温度

hard negative mining中起着关键作用。Figure 7展示了模型性能随不同我们可以观察到:

(1):增大1.0)会导致性能变差,且需要更多训练epochs才能收敛,这是因为难以区分hard negatives和easy negatives。(2):相反,将0.1)会损害模型性能,因为少量的negatives的梯度主导了优化过程,失去了在自监督学习目标中添加多个负样本的优势。

简而言之,我们建议在

0.1 - 1.0范围内仔细调优

预训练的影响:上述实验已经证明了

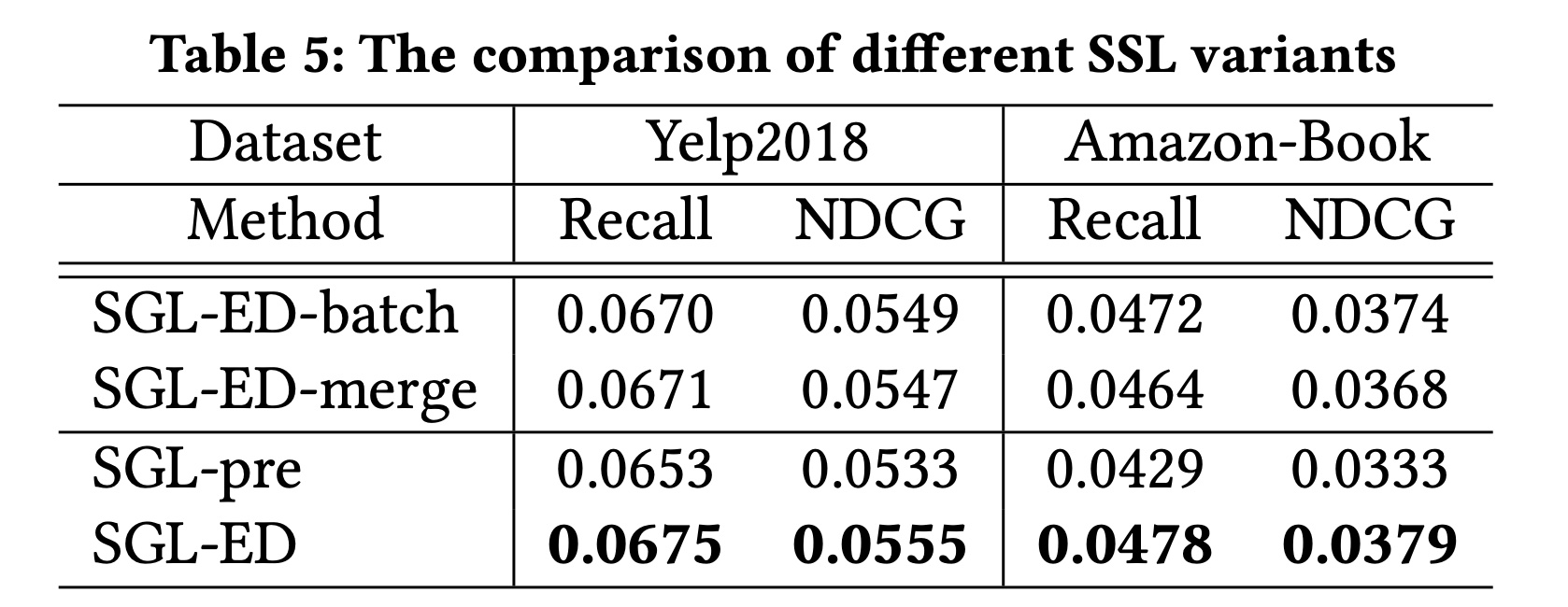

SGL的有效性,其中主体监督任务和自监督任务是联合优化的。这里我们想回答一个问题:推荐性能能从pre-trained模型中受益吗?为了实现这一目标,我们首先预训练自监督任务以获得模型参数,用这些参数初始化LightGCN,然后通过优化主体任务对模型进行微调。我们将这个变体称为SGL-pre,并在Table 5中展示其与SGL的比较结果。显然,尽管

SGL-pre在两个数据集上的性能都不如SGL-ED,但它的结果仍优于LightGCN(见Table 3)。我们的自监督任务能够为LightGCN提供更好的初始化,这与先前研究(《A Simple Framework for Contrastive Learning of Visual Representations》)中的观察结果一致。然而,联合训练的更好性能表明,主体任务和辅助任务中的

representations相互增强。

负样本的影响:此外,我们还研究了辅助任务中负样本选择的影响。考虑两个变体:

(1) SGL-ED-batch:它区分节点类型,将一个mini-batch中的用户和item分别视为用户和items的negative views。(2) SGL-ED-merge:它将一个mini-batch中的节点视为负样本,不区分节点类型。

我们在

Table 5中报告比较结果。SGL-ED-batch的性能优于SGL-ED-merge,这表明区分异质节点类型的必要性。此外,

SGL-ED-batch与将整个spaces of users and items视为负样本的SGL-ED性能相当。这表明在mini-batch中训练自监督学习任务是一种有效的替代方法。